Experteninterview mit Vitali Losing von INNERECOMMERCE zur Datenqualität im E-Commerce - Teil 1

Über das Thema Datenqualität im E-Commerce haben wir mit Vitali Losing, E-Commerce-Experte & Gründer der INNERECOMMERCE GmbH, gesprochen.

Datenqualität (oder auch Data Quality) bezeichnet die Erfassung sowie Aufbereitung von Daten (Informationen) und stellt deren Zustand bzw. Qualität fest. Dabei unterscheidet man zwischen guter und schlechter Datenqualität. Beide Zustände – sowohl gute als auch schlechte Datenqualität – können positive oder negative Auswirkungen auf das Unternehmen haben.

Bud Walker, CIO von Melissa, erläutert, wie aus einer isolierten Betrugsbekämpfung eine integrierte Strategie zur Vertrauensbildung entwickelt werden kann.

Die transformierende Kraft der Künstlichen Intelligenz (KI) verspricht in vielen Fällen, den Erfolg im Handel nachhaltig zu steigern, indem datengestützte Erkenntnisse präzisiert und die Customer Experience optimiert werden.

In Deutschland kaufte im Jahr 2023 rund ein Viertel der Bevölkerung wöchentlich über das Mobiltelefon ein.¹ Was für Kunden bequem ist, führt bei E-Commerce-Anbietern jedoch häufig zu Problemen. Greg Brown zeigt fünf Möglichkeiten auf, wie eine hohe Kontaktdatenqualität in Zeiten des mobilen Commerce gelingen kann.

In einem zunehmend wettbewerbsintensiven Markt sind Unternehmen gefordert, im Rahmen der elektronischen Identitätsprüfung (eIDV) akkurate, standardisierte und aktuelle Kontaktdaten zu nutzen. So lassen sich Überprüfungsfehler reduzieren, Prozesse rationalisieren und Betrugsversuche zuverlässig erkennen – gleichzeitig wird eine herausragende Customer Experience gewährleistet.

In einem ersten Interview haben wir mit Vitali Losing über die Bedeutung einer hohen Datenqualität im E-Commerce gesprochen. Heute sprechen wir mit dem E-Commerce-Experten und Gründer der INNERECOMMERCE GmbH über deren Auswirkungen auf Prozesse, Kosten und den ROI.

Das Thema Datenqualität hat gerade im E-Commerce eine hohe Priorität. Über die Hintergründe sprachen wir mit Vitali Losing, E-Commerce-Experte mit fundierten Branchenkenntnissen und Gründer der INNERECOMMERCE GmbH.

Köln. Melissa Data hat heute ein kostenloses Plug-in für Shopify veröffentlicht. Damit können Händler, die einen Online-Shop auf Basis der beliebten E-Commerce-Software betreiben, Kundenadressen bereits während der Eingabe in Echtzeit überprüfen, korrigieren und auf das offizielle länderspezifische Anschriftenformat standardisieren.

Die Melissa Data GmbH zeigt auf der E-commerce Berlin Expo, wie E-Tailer eine positive Customer Experience schaffen, Retourenkosten senken und sich vor Betrug schützen können.

Black Friday und Cyber Monday gehören heute zu den wichtigsten Umsatzboostern für den Handel. Um das immense Potenzial dieser Aktionstage tatsächlich auszuschöpfen, sind Online-Shops gefordert, ihren Kunden über alle Touchpoints hinweg eine nachhaltig positive Customer Journey zu bieten und sie zu binden. Grundlage dafür ist eine hohe Datenqualität, die gleichzeitig vor Betrug schützt.

Die Begriffe „Validierung“ und „Verifizierung“ werden im Umfeld der Adressdatenpflege häufig synonym verwendet. Sie unterscheiden sich jedoch in vielerlei Hinsicht. In diesem Beitrag gehen wir auf die Unterschiede ein und erläutern, warum eine geschickte Kombination beider Verfahren sinnvoll ist.

Vor wenigen Wochen verhängte die BaFin gegen die Commerzbank Bußgelder in Höhe von insgesamt 1,45 Millionen Euro. Der Grund war, dass die Bank ihre Aufsichtspflichten zur Geldwäscheprävention verletzt hatte, indem sie unter anderem Kundendaten nicht fristgerecht oder ausreichend aktualisierte.

Unser Geschäftsführer Çağdaş Gandar hat bereits in den zwei vorherigen Beiträgen aufgezeigt, dass eine hohe Datenqualität zu höheren Umsätzen und geringeren Kosten führt. In diesem Beitrag beschreibt er weitere Bereiche, in denen eine hohe Datenqualität ebenfalls den Unternehmenserfolg sichert.

Unser Geschäftsführer Çağdaş Gandar hat im vergangenen Beitrag erste Argumente dafür geliefert, dass sich das Investment in eine hohe Datenqualität aufgrund höherer Umsätze rechnet. Heute drehen wir den Spieß um und zeigen, wie sich eine schlechte Datenqualität auf die Kosten auswirkt.

Wirtschaftlicher Abschwung, steigende Energiepreise, hohe allgemeine Inflation, Fachkräftemangel – die Liste der schlechten Rahmenbedingungen, mit denen deutsche Unternehmen heute und ...

Das digitale Onboarding wird heute immer beliebter. Deshalb sollten Unternehmen es optimieren, um Interessenten von Anfang eine positive User Experience zu bieten.

Hohe Retourenquoten sind für E-Commerce-Anbieter ein lästiges Übel. Sie verursachen unnötige Kosten und erhöhen den CO2-Ausstoß.

Spätestens seit der Veröffentlichung von ChatGPT ist das Thema Künstliche Intelligenz (KI) in aller Munde. Marketingverantwortliche versprechen sich vom Einsatz solcher intelligenten Technologien unter anderem, ihren Kunden ein auf sie zugeschnittenes Kauferlebnis bieten zu können. Dazu werden ...

Nachdem Corona bei Online-Händlern für Rekordumsätze gesorgt hatte, trat im vergangenen Jahr Ernüchterung ein. So meldete der Bundesverband E-Commerce und Versandhandel Deutschland e. V. (bevh) im Oktober 2022, dass die Umsätze im E-Commerce ...

Die Datenqualität hat grundsätzlich einen hohen Einfluss auf den Unternehmenserfolg. Dies trifft insbesondere für B2C-Anbieter zu. Sie sind in der Regel mit einer hohen Wettbewerbsintensität konfrontiert und müssen dementsprechend mit ...

Köln. Heimspiel für Melissa auf dem e-Commerce Day, der am 5. Mai 2023 im Kölner Rhein-Energie-Stadion stattfindet. Das Software-Unternehmen wird ...

Die Adress- und Kontaktdaten von Kunden und Interessenten zählen zu den wertvollsten Daten eines Unternehmens. Ihre Qualität hat einen hohen ...

Die aktuellen Softwarelösungen entsprechen nicht mehr den Anforderungen, der bisherige Software-Anbieter ist in die Insolvenz gegangen, die Unternehmens-IT wechselt in ...

Köln. Melissa, ein führender Anbieter globaler Datenqualitäts- und Adressmanagementlösungen, ist seit nunmehr einer Dekade mit einer GmbH in Deutschland präsent ...

Max Mustermann, Mustermann Max, M. Mustermann … ein Name, zahlreiche Varianten. Das Risiko, dass Unternehmen Kontaktdaten mehrfach vorhalten, ist groß ...

Mit der Datenqualität steht und fällt der Unternehmenserfolg. So verursachen inkorrekte Daten hohe Kosten, manuelle Korrekturaufwände und Verzögerungen in Lieferkette ...

Das Internet kennt bekanntermaßen keine Grenzen – was internationalen E-Commerce-Anbietern natürlich in die Karten spielt. Sie können ohne Weiteres einen ...

Wer im Internet einkaufen möchte, hat die Qual der Wahl: Beim Googeln nach dem gewünschten Produkt werden zahlreiche Anbieter angezeigt ...

Melissa zum dritten Mal infolge im Bericht positioniert Köln. Gartner hat Melissa, einen führenden Anbieter globaler Datenqualitäts- und Adressmanagementlösungen, erneut ...

Supermärkte, Möbelhäuser, Fluggesellschaften, Hotelketten – zahlreiche Unternehmen unterhalten Loyalitätsprogramme. Kunden profitieren unter anderem von Rabattaktionen, vergünstigten Angeboten oder Gratisprämien. Anbieter ...

Das Thema Marketing-Automation – eine Teildisziplin des Customer-Relationship-Managements – bezeichnet alle Aktivitäten in Verbindung mit Softwarelösungen, die ...

Im Rahmen einer Umfrage von IDC bemängelten 37 Prozent der Befragten, dass sie nicht in der Lage seien, eine hohe Datenqualität zu gewährleisten. Allerdings können nur validierte Kundendaten ...

Kunden reagieren verärgert oder sind unzufrieden, wenn die bestellte Ware erst spät ankommt oder gar nicht erst zugestellt wird. Darunter leidet die Customer Experience, und die Wahrscheinlichkeit, dass der Kunde künftig woanders bestellt, ist hoch. Allerdings ...

Kunden werden immer anspruchsvoller und erwarten sowohl im stationären Handel als auch im Internet ein positives Einkaufserlebnis. Damit dieser Erwartung entsprochen werden kann, ...

„Daten sind das neue Gold.“ Dieses oftmals verwendete Zitat klingt einerseits abgedroschen, ist aber andererseits nach wie vor zutreffend und oftmals ist in Big-Data-Beiträgen von der neuen Währung die Rede. Was leider häufig vernachlässigt wird, ist ...

Laut einer Studie 1 des Verbands Deutscher Maschinen- und Anlagenbau e. V. (VDMA) ist in Unternehmen mit Abstand die größte Herausforderung die Datenpflege. 84 Prozent der Umfrageteilnehmer schätzen den damit verbundenen Aufwand zur Eingabe, Suche und Pflege von Daten als hoch ein. „Hier sollten Unternehmen ansetzen, denn ...

Die Unternehmen innoscale AG und Melissa vertiefen ihre Zusammenarbeit und ermöglichen Unternehmen damit ein umfassendes, aber dennoch einfaches Datenqualitätsmanagement. Das Master Data Management System DataRocket wird erweitert um die Lösungen von Melissa ...

Unternehmen, insbesondere jene aus dem E-Commerce, verfügen in ihren Systemen über zahlreiche Daten. Mithilfe einer kontinuierlichen Datenanreicherung lassen sich diese effizient nutzen (Stichwort: Smart Data). Erfahren Sie in diesem Beitrag, was ...

Ob es sich um die Lieferung von Waren, um Werbesendungen oder geschäftliche Korrespondenz handelt – falsche Kundennamen und -adressen sind mit zahlreichen Nachteilen verbunden. Sie müssen aufwendig korrigiert werden und es kommt zu Verzögerungen bei der Zustellung oder gar zu Rücksendungen.

Vor knapp sechs Jahren trat die Datenschutz-Grundverordnung (DSGVO) in Kraft. Nahezu alle Unternehmen mussten darauf reagieren, da die Vorschrift große Veränderungen im Umgang mit Daten erforderte.

Ob E-Commerce, Transport und Logistik, Banken, öffentlicher Sektor oder andere Bereiche – überall werden Daten von Interessenten, Kunden sowie Geschäftspartnern erhoben, manchmal sogar mehrfach. Eine regelmäßige Aktualisierung findet häufig nicht statt, sodass ...

Köln. Gartner hat Melissa, einen führenden Anbieter globaler Datenqualitäts- und Adressmanagementlösungen, erneut als Nischenplayer im „Magic Quadrant for Data Quality Solutions“1 positioniert. Melissa Data ist dabei eines von ...

Köln. „Strategische Unternehmensführung durch Stammdatenmanagement“ – unter diesem Titel hat Melissa ein neues Whitepaper veröffentlicht. Darin zeigen die Experten ...

Immer mehr Händler wagen den Sprung auf das internationale Parkett. Sie haben dafür ihre Online-Shops angepasst und Produktbeschreibungen entsprechend übersetzt. Damit eingehende Bestellungen ...

Köln. Melissa, ein führender Anbieter globaler Datenqualitäts- und Adressmanagementlösungen, hat heute bekannt gegeben, dass Gartner das Unternehmen als Nischenanbieter im Magic Quadrant für Datenqualitätslösungen1 positioniert hat. Melissa ist einer von ...

„Daten sind das neue Gold.“ Dieses oftmals verwendete Zitat klingt einerseits abgedroschen, ist aber andererseits nach wie vor zutreffend. Oftmals ist in Big-Data-Beiträgen von der neuen Währung die Rede. Was leider häufig vernachlässigt wird, ist ...

Köln/München. Besucher der diesjährigen Internet World können sich am Stand von Melissa (Nummer: CO38) umfassend über das Thema internationale Adressprüfung informieren.

Köln. Melissa, ein führender Anbieter von globalen Lösungen zur Adress-, Namens-, E-Mail-, Telefon- und Identitätsprüfung, feiert sein 35-jähriges Firmenjubiläum. Das lange Bestehen von Melissa ...

Wenn Kunden einer Marke den Rücken kehren, dann ist es in der Regel der Fall, wenn sie das Gefühl haben, vom Anbieter nicht wahrgenommen zu werden. Zwar kümmern sich ...

Als Synonym für Datenqualität wird oft der Begriff „Informationsqualität“ verwendet. Das ist aber nur bedingt richtig. Nichtsdestotrotz stehen sich die Begriffe nahe bzw. folgen aufeinander. Die Grundlage für Informationen sind Daten, daher wirkt sich die Datenqualität auf die Qualität der Informationen aus, die aus den Daten gewonnen werden. So können zum Beispiel keine „guten“ Informationen aus schlechten Daten generiert werden.

Darüber hinaus wird Informationsqualität oftmals mit hoher Qualität gleichgesetzt. Allerdings fehlt zu solch einer wertenden Aussage eine relativierende Betrachtung, da die Qualität an bestimmten Merkmalen, Kennzahlen oder Anforderungen festgemacht werden muss. Deshalb ist die Qualität einer Information immer abhängig vom Kontext und / oder vom Nutzen und sollte niemals isoliert betrachtet werden.

Daten sind zu einem wesentlichen Aspekt jedes Unternehmens geworden. Besonders für Entscheider ist die Datenqualität ausschlaggebend. Deren Basis bietet die Grundlage für viele (weitreichende) Entscheidungen. Laut Gartner Research sind schlechte, falsche und/oder unvollständige Daten für 9,7 Mio. Dollar Schaden pro Unternehmen verantwortlich.¹ Aber es entstehen nicht nur Umsatzverluste. Zusätzlich entstehende Kosten (z.B. für Transport, Recherche, Material) oder die Beschädigung der Reputation sind negative Auswirkungen von schlechter Datenqualität. Insbesondere bei Big-Data-Anwendungen/-Projekten sind die Daten größer, vielfältiger und schneller, was das Thema Datenqualitätsmanagement noch wichtiger macht.

Zudem bringt eine hohe Datenqualität zahlreiche Vorteile mit sich und ist deshalb so wichtig:

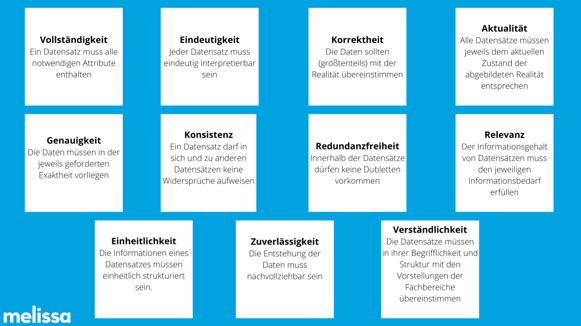

Um die Datenqualität zu messen, gibt es bestimmte Kennzahlen. Am bekanntesten sind die folgenden elf Datenqualitätskriterien:

Eine hohe Datenqualität ist ein fortlaufender Prozess. Zu Beginn sollte mit allen Fachbereichen ein Single Point of Truth bestimmt werden – ein System, wo zukünftig alle Daten gespeichert und genutzt werden. So werden Datensilos aufgelöst und Dubletten vermieden. Ab dem Zeitpunkt, an dem eine saubere Basis vorliegt (z.B. Adressprüfung via Batch-Verfahren), sollten Unternehmen die Daten direkt bei der Erfassung am Point-of-Entry validieren und überprüfen lassen (z.B. mithilfe einer Adressvalidierung). Damit gelangen nur noch korrekte Daten in das System und eine Gewährleistung der Datenqualität ist sichergestellt. Wenn diese Schritte getan sind, empfiehlt sich ein Datenqualitätsmanagement, womit die Daten laufend überwacht und kontrolliert werden. Letztendlich lohnt sich hier jeder Euro, da die Kosten, einfach nichts zu tun, um ein Vielfaches höher ausfallen.

Quellen:

¹ https://www.dnb.com/de-de/wissen/studien/datenqualitaet-die-4-kriterien/

Über das Thema Datenqualität im E-Commerce haben wir mit Vitali Losing, E-Commerce-Experte & Gründer der INNERECOMMERCE GmbH, gesprochen.

Valide Kundendaten sichern den Unternehmenserfolg. Dabei bildet eine hohe Datenqualität das Fundament für Entscheidungen.

Stammdaten sind Grunddaten, die für Unternehmen relevant sind. Lesen Sie hier unsere Beiträge zum Thema Stammdatenmanagement.